در چند سال اخیر و بهخصوص پس از ظهور چت جیبیتی و ابزارهای رایگان هوش مصنوعی، آشنایی مردم با این پدیده بیشتر شد. آنها در بسیاری از موارد، از این ابزارها برای سرگرمی و گذران وقت خود استفاده کردهاند و در بهترین حالت بهعنوان دستیار تولیدمحتوا از او کمک گرفته یا سوالات تحقیقاتی خود را از او پرسیدند. آشنایی عموم مردم با هوش مصنوعی در همین حد است اما اگر بخواهیم یک لایه عمیقتر شویم، میبینیم که چالشهای فراوانی در این حوزه وجود دارد که فعلا چارهای برایش اندیشیده نشده و یا با توجه به پیشرفتهای علمی حالحاضر، فعلا غیرقابلحل بهنظر میرسد.

این چالشها صرفا فنی و فناورانه نیستند و در برخی موارد بعد فلسفی و اخلاقی بهخود میگیرند. در این مقاله کوتاه قرار است که درباره یکی از مهمترین چالشهای موجود در این حوزه صحبت کنیم و آن چیزی نیست جز عدم توانایی الگوریتمهای هوش مصنوعی در تشخیص درست و غلطبودن هر دادهای که به او داده میشود. بهتر است فراموش نکنیم که هوش مصنوعی صرفا ماشینی است که الگوهای موجود در دادهها را کشف میکند و اگر شما در دادن دادههای آموزشی به آن دقت کافی را نداشته باشید، به احتمال زیاد، الگوریتمهایش صرفا باورهای کنونیتان را تقویت میکند.

هوش مصنوعی این قابلیت را دارد که از طریق بازتاب پیشفرضها، منافع شخصی/گروهی و جهانبینی توسعهدهندگانش، به وضعیت کنونی که در هر سیستمی تبعیضآمیز است، دامن بزند. این مسالهای در سطح کارشناسی و فنی نیست که مهندسان و برنامهنویسان نگران آن باشند بلکه یک چالش در سطح مدیریت ردهبالا و حتی سیاستگذاری است که عدم توجه به آن، در طولانیمدت ممکن است هزینههای فرهنگی به بار بیاورد.

علاوهبر این، الگوریتمهای ماشینلرنینگ، که در حال حاضر مورداستفادهترین بخش هوش مصنوعی هستند، بهدنبال کشف الگو در مثالهای دنیای واقعی (training data) میباشند که این مساله مشکلاتی را پدید میآورد:

- محدودبودن دادههای آموزشی به یک پیشزمینه فرهنگی

- مشمول نشدن سهوی گروهی خاص در دادههای آموزشی

بهعبارت دیگر، مشکل اینجا است که مجموعه دادههای آموزشی دربرگیرنده دقیقا تمامی عدم برابریها و تعصبهای دنیای واقعی است و الگوریتمهای ماشینلرنینگ قادر به تشخیص آنها نبوده و ممکن است که صرفا شرایط را بدتر کنند.

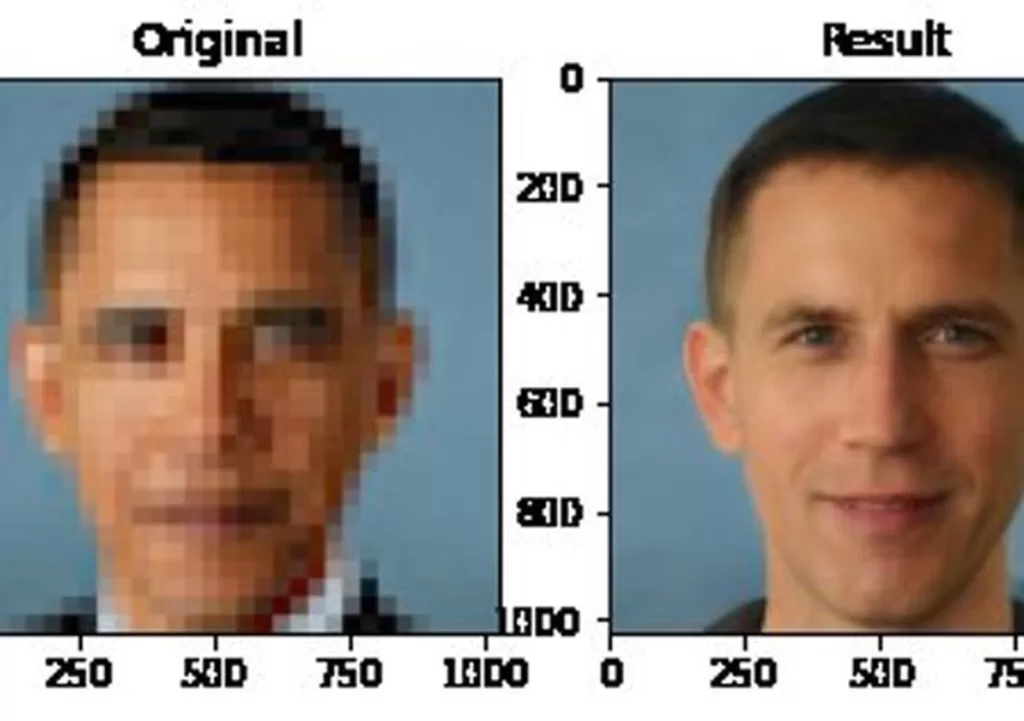

مثالهای زیادی وجود دارد که هوش مصنوعی تعصب و عدم برابری در دنیای واقعی را شدیدتر کرده و نتیجهاش حتی کاملا سهوی نژادپرستانه شده است. مشهورترین مثال از این وضعیت مربوط به سیستمی است که طراحی شده بود تا عکسهای مات و بیکیفیت را اصلاح کرده و یک عکس تمیز و شفاف تحویل داد. خروجی عجیبی که مشاهده شد این بود که در هر دور از پیادهکردن الگوریتم مربوطه، چهرههای افراد سیاهپوست ذرهذره سفید میشدند. این اتفاق در زمان ریاست جمهوری باراک اوباما اتفاق افتاد و سروصدای زیادی کرد.

حال این یک مثال ساده است که اثرات فیزیکی آن واضح بوده و بهراحتی قابل تشخیص است. اثری که هوش مصنوعی در تثبیت مسائل عمیقتر فکری و ذهنی میتواند داشته باشد غیرقابلتشخیصتر بوده و منجر به تثبیت و تایید باورهای کنونی انسانها میشود.

راهحلی که پژوهشگران کنونی این حوزه ارائه دادهاند درواقع تلاش درجهت فرمولهکردن و کدگذاری fairness با استفاده از مفهومی به اسم proxy variables که درواقع متغیرهایی هستند که مقدارشان با دیدگاه گروهی از مردم که نظراتشان اغلب نادیده گرفته شده همبستگی بالایی دارند.

تلاشها درجهت فرمولهکردنfairness اغلب منجر به اقرار به موازنه موجود میان صداها و نظرات مختلف در جامعه گردیده است اما مشکل همچنان پابرجا مانده و صدای غالب اثرگذاری خود را حفظ میکند.

مساله دیگری که وجود دارد این است که صرفا تلاش در جهت فرمولهکردن fairness باعث میشود که تغییر سختتر شده و اجازه ظهور به سیستمهای نوآوری که شرایط کنونی را به چالش میکشد، داده نشود.

پاسخ شما به دیدگاه